Ollama的魅力——大模型时代的“平民英雄”

在人工智能浪潮席卷全球的今天,大语言模型(LLM)无疑是最耀眼的明星。然而,对于许多初学者和开发者而言,大模型的部署和使用门槛依然不低。正是在这样的背景下,Ollama应运而生,并迅速以其极致的易用性俘获了大量用户的心。

Ollama的设计哲学可以概括为“一键启动”。用户无需关心复杂的环境配置和模型加载流程,只需一条简单的命令,即可在本地轻松运行和管理像Llama 3、Mistral等主流的开源大模型。这种“开箱即用”的体验,极大地降低了开发者和研究人员进入大模型领域的门槛。可以说,Ollama是许多人探索大模型世界的第一个“脚手架”,是他们学习和实验的得力助手。正是因为这种无与伦比的便捷性,Ollama的用户基数非常庞大,在开发者社区中拥有极高的声誉和使用量。

然而,Ollama在为用户带来便利的同时,也埋下了一颗危险的“定时炸弹”——安全性的缺失。令人惊讶的是,直到目前为止,Ollama仍然没有内置任何形式的身份验证或访问控制机制。 这意味着,一旦Ollama的服务端口(默认为11434)被暴露在公共网络上,任何能够访问该端口的人,都可以不受限制地调用其所有的API接口。

这种“不设防”的状态带来了严重的安全隐患。攻击者可以像使用自家的本地服务一样,对暴露在外的Ollama实例为所欲为。以下是一些可能被利用的敏感操作:

事实上,目前已知的多个与Ollama相关的安全漏洞,其根源几乎都指向了这个致命的缺陷——未经身份验证的访问。

Ollama默认监听的是本地回环地址(127.0.0.1),这在设计上是安全的。但问题在于,很多用户为了方便远程访问或在容器化环境中部署,会将其配置为监听所有网络接口(0.0.0.0)。这一小小的改动,如果没有其他网络层面的防护(如防火墙),就相当于将Ollama完全暴露在了广阔的互联网上。

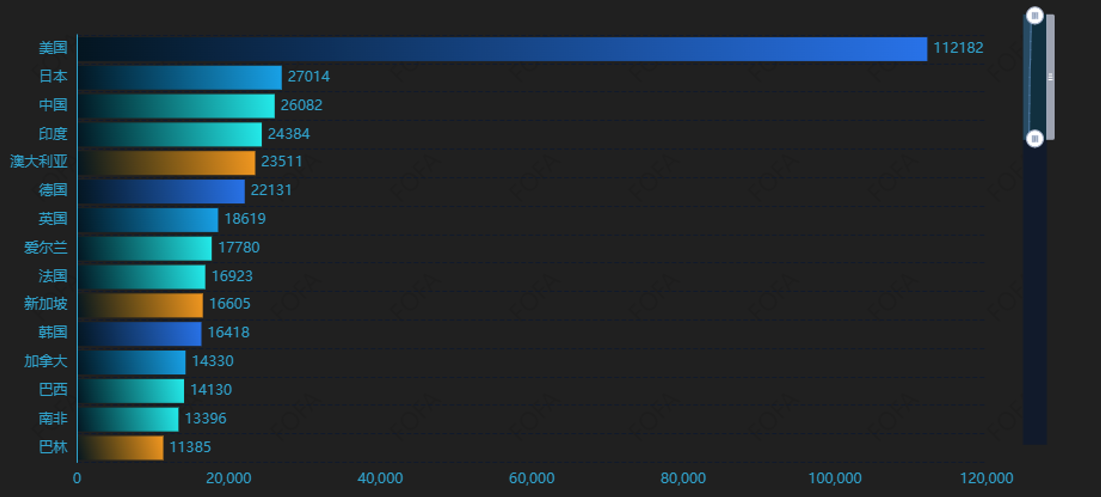

根据最新的全球网络空间扫描数据显示,当前有几十万个Ollama实例正毫无防护地暴露在公网上。

这个数字是触目惊心的。每一个暴露的实例都是一个潜在的受害者,其背后可能连接着个人的开发项目、企业的内部数据,甚至是敏感的研究成果。这些用户或许根本没有意识到,自己精心调试的模型和宝贵的计算资源,正处于随时可能被“白嫖”甚至恶意利用的危险之中。

亡羊补牢,为时未晚。既然Ollama自身不提供安全机制,我们就需要借助外部工具来构建一道坚固的防线。以下是两种主流且行之有效的解决方案。

最直接的思路是在Ollama前面架设一个反向代理服务器,例如Nginx、Caddy或Apache。由反向代理来负责处理所有传入的请求,并在这里添加身份验证机制。

以Nginx为例,我们可以轻松地为其配置HTTP Basic Authentication。这样,任何访问者在接触到Ollama的API之前,都必须提供预设的用户名和密码。这种方式实现简单,可以快速地为你的Ollama服务提供一层基础的保护,有效阻止未经授权的访问。

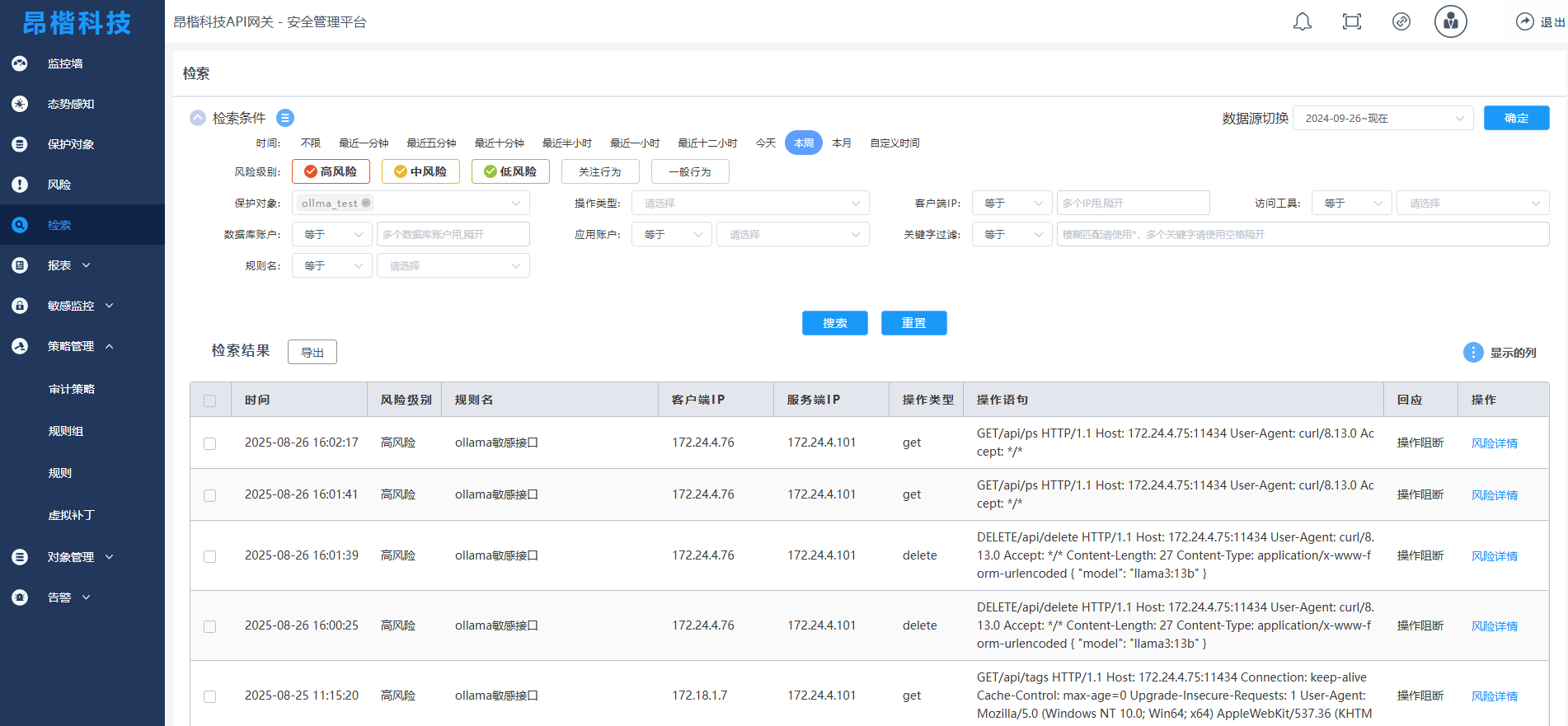

相比于反向代理的“一刀切”式防护,昂楷API网关提供了更为精细化和强大的访问控制能力。昂楷API网关不仅能实现身份认证,还能对API进行更细致的权限管理,例如限制特定API的访问、流量控制、日志记录等。

这种方案的优势在于,我们可以根据实际需求,制定差异化的安全策略。例如,我们可以设想这样一个场景:允许外部用户通过 API调用模型进行推理(访问api/generate/或/api/chat接口),但绝对禁止他们创建、删除或修改模型(禁止访问/api/create、/api/delete、/api/push等高危接口)。

(阻断了除/api/generate、/api/chat之外的所有接口)

通过昂楷API网关,我们可以轻松实现这种策略。我们可以配置网关,为不同的API路径设置不同的认证和授权规则。只有通过认证且具备相应权限的用户,才能访问特定API。

这种方式不仅提升了安全性,也增强了服务的可管理性和扩展性,是企业级应用场景下的更优选择。

Ollama的成功,在于它将复杂的技术变得简单。但我们必须清醒地认识到,这种简单性不应以牺牲安全为代价。将一个没有任何访问控制的服务暴露在互联网上,无异于“裸奔”,是对自己和他人的不负责任。

幸运的是,我们有成熟的工具和策略来弥补这一短板。无论是简单直接的反向代理,还是功能强大的API网关,都能有效地为你的 Ollama实例保驾护航。对于每一位正在享受Ollama便利的开发者而言,都应该立即行动起来,检查自己的部署配置,为你的Ollama“穿上”必要的安全外衣。毕竟,在数字世界里,安全永远是第一位的。